2. 广州市刑事科学技术研究所 & 法医病理学公安部重点实验室,广东 广州 510030;

3. 肇庆学院计算机科学与软件学院,广东 肇庆 526061;

4. 广州竞赢科学仪器有限公司,广东 广州 510507;

5. 南方医科大学,广东 广州 510515

2. Guangzhou Forensic Science Institute and Key Laboratory of Forensic Pathology, Ministry of Public Security, Guangzhou 510030, China;

3. School of Computer Science and Software, Zhaoqing University, Zhaoqing 526061 China;

4. Guangzhou Jingying Scientific Instrument Co., Ltd, Guangzhou 510507, China;

5. Southern Medical University, Guangzhou 510515, China

硅藻的识别在法医学检验中的作用十分重要[1-3],是对尸体溺死诊断最有效的方法。但是硅藻通过高清电子扫描显微镜成像时,往往包含着细微砂石、颗粒和其它微生物、组织等形成的复杂背景。这些复杂背景在结构、纹理、像素灰度值分布上与硅藻存在一定的相似性,严重干扰了硅藻的自动识别。

目前针对硅藻进行自动识别与定位的研究主要集中在简单背景下的藻类图像的识别。传统机器学习算法[4-8]使用特征提取算法提取藻类图像的形状特征[9-10]、纹理特征[11-12]来组成具有代表性的特征集合,然后训练分类器[13-14]来实现图像的自动分类。传统机器学习算法虽然对数据量的需求较少,但是只能人工设计特征集,训练得到的分类器模型泛化能力差且容易受到背景的干扰。随着深度学习算法的兴起,CNN[15]以及基于不同CNN[16-18]的各种目标检测框架如:R-CNN[19-22]系列、YOLO[23]、SSD[24]等广泛应用在汽车识别[25]、文字识别[26]、广告推荐[27]等方向,虽然也有少量算法用于硅藻图像[28-29],但是也仅用于简单背景下的识别或者目标检测任务。

综上所述,鲜有研究应用深度学习网络对法医学检验中受复杂背景干扰的硅藻图像进行自动识别与定位。因此本文提出应用深度学习网络自动识别与定位复杂背景干扰下的硅藻图像。深度学习网络有多种,Fang等[30]应用Faster R-CNN识别和定位建筑工地中的挖掘机和工人。在识别与定位过程中,挖掘机与工人受到工地中的建材、石头、泥土、散石以及周边建筑等复杂背景的干扰,但是FasterR-CNN仍然有效识别与定位目标对象。受到该场景启发,本文提出应用Faster RCNN识别和定位复杂背景下的硅藻。该方法由两大模块组成,分别是初步定位与精确定位模块。在初步定位模块中,应用ZFNet的卷积层、池化层提取硅藻特征,然后应用RPN (Region Proposal Network)生成可能存在硅藻的区域并且完成硅藻目标的初步定位。在精确定位中,应用Fast R-CNN精确修改硅藻位置信息与识别硅藻类别。实验结果表明本文所用方法在复杂背景下能够有效的自动识别与定位常见的硅藻。

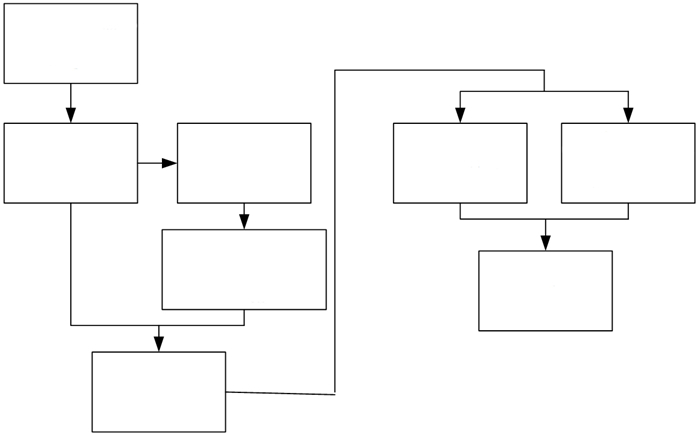

1 基于Faster R-CNN的硅藻目标检测算法本文提出的基于Faster R-CNN的硅藻目标检测算法主要由两大模块组成:RPN模块和Fast R-CNN目标检测模块。其中RPN模块用于提取图像中存在硅藻目标的区域,初步完成目标定位,Fast R-CNN模块用于提取该区域特征然后对硅藻目标进行种属鉴定的同时对目标进行定位,算法流程如图 1所示。

|

图 1 Faster R-CNN算法流程图 Fig.1 Flow chart of Faster R-CNN. |

ZFNet基于AlexNet网络模型做了一些微调,主要区别是使用步长为2,7×7的卷积核代替了AlexNet中步长为4,11×11的卷积核且调整了3、4、5卷积层卷积核的数量,在可视化过程中发现第一层卷积核影响较大,因此对第一层卷积核做了规范化处理。

1.1.2 ZFNet中的卷积过程ZFNet网络中共有5个卷积层且padding=0、5个Relu激活函数层、3个池化层,池化方式为max pooling、两个全连接层以及最后的softmax分类层,头两个连接层后面加0.5的Dropout[31]。其中卷积操作公式如下:

| $ g=\sum\limits_{m, n}{f\left( i+m, j+n \right)}h\left( m, n \right) $ | (1) |

| $ wid={\left( f+2*padding-\ker \ nel\_size \right)}/{s\ \text{tr}\ ide+1}\; $ | (2) |

| $ hei={\left( f+2*padding-\ker \ nel\_size \right)}/{s\ \text{tr}\ ide+1}\; $ | (3) |

公式(1)中g是输出的卷积响应图像,f是输出该卷积层的图像,i、j的取值分别为f的宽和高,h是卷积核的大小,m、n的取值区间为[-kernel_size/2, kernel_size/2],公式(2)、(3)中stride为卷积的步长,wid和hei分别是卷积输出的特征图像的宽和高。

1.1.3 池化操作池化操作是指用某一位置的相邻输出的总体统计特征来代替网络在该位置的输出。ZFNet中采用max pooling池化方法,使用3×3,步长为2的核来进行池化操作,池化操作的公式如下:

| $ \begin{array}{l} P = g\left( {{f^*}k} \right) = \max {\left( {f\left( {i + m,j + n} \right)} \right.^*}\\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\left. {\ker \;nal\left( {m,n} \right)} \right) \end{array} $ | (4) |

其中,P为池化操作后的输出矩阵,f为输入的卷积响应图像,g为寻找最大值的函数,其作用是寻找f、k两个矩阵进行运算后矩阵中的最大值。

1.1.4 Dropout2012年,文献[31]中提出使用Dropout来防止复杂的前馈神经网络在训练小的数据集时容易发生的过拟合现象。

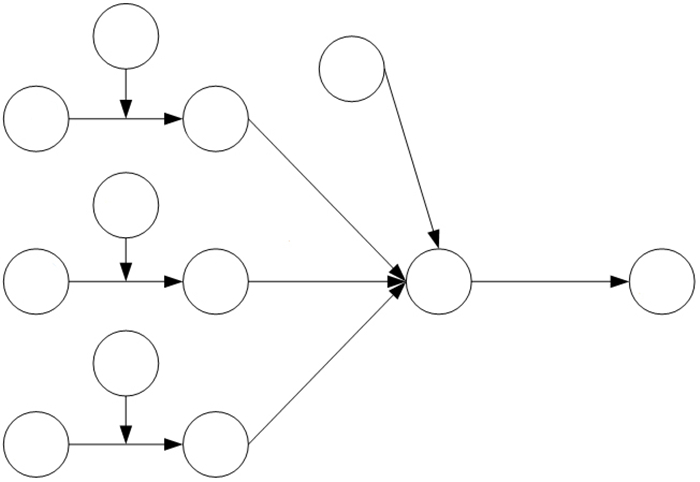

Dropout的原理如图 2所示,是在深度神经网络的每个训练批次前向传播的过程中,以一定的概率P使得某个神经元停止工作,以此来减少隐藏节点之间的相互依赖性,明显减少过拟合现象。其主要过程是先删除一部分隐藏的神经元,然后在一个mini_batch的训练样本训练完成后在没有停止工作的隐藏神经元上按照SGD[32](Stochastic Gradient Descent)算法更新其参数。更新完成将网络恢复并且使用下一个mini_batch的样本重复上面的步骤,其运算公式如下:

|

图 2 Dropout原理示意图 Fig.2 Dropout schematic diagram. |

| $ r_{i}^{\left( l \right)}=Bernoulli\left( p \right) $ | (5) |

| $ {{\tilde{y}}^{\left( l \right)}}={{r}^{\left( l \right)}}*{{y}^{\left( l \right)}} $ | (6) |

| $ z_{i}^{\left( l+1 \right)}=w_{i}^{\left( l+1 \right)}\overset{\sim l}{\mathop{y}}\, +b_{i}^{\left( l+1 \right)} $ | (7) |

| $ y_{i}^{\left( l+1 \right)}=f\left( z_{i}^{\left( l+1 \right)} \right) $ | (8) |

其中,Bernoulli函数用于生成概率r向量,即随机生成0-1之间的概率值,y(l)是神经元的原始输入值,ỹ(l)是添加生成概率向量之后的输入,ZFNet中如果r(l)>0.5则该输入变为0;zi(l+1)是该神经元接收到的输入加上权重和偏置后的值,yi(l+1)是zi(l+1)经过激活函数之后的输出。

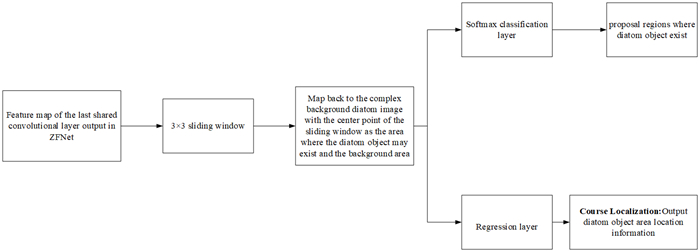

1.2 RPN模块RPN是一个全连接网络模型,主要用于生成可能存在硅藻目标的候选区域以及完成硅藻目标的初步定位。RPN的输入是共享卷积层中的最后一个卷积层(本文中使用ZFNet的五个卷积层全部做为共享卷积层),使用3×3滑窗在最后一个共享卷积层生成的特征图上滑动,在每一个滑窗的中心点位置使用3种尺度[22](128、256、512)和3种长宽比(1:2、2:1、1:1)映射到输入的原硅藻图像中共生成九个anchor,这部分是Faster R-CNN算法中的核心内容。通过映射在原图中的不同尺度不同比例的anchor基本可以覆盖原图中所有区域的目标,并且具有尺度不变性和旋转不变性,通过共享卷积层来生成候选区域,极大的减少了目标检测算法中候选区域提取需要花费的时间,解决了RCNN系列算法中的瓶颈问题[22]。后续计算由两部分组成,一部分通过softmax分类器来对获取的anchor进行二分类,仅选取存在硅藻目标的候选区域进入后续算法流程。训练过程中通过IOU (Intersection over Union)来对生成的anchor标定前景或者背景标签,IOU是指训练过程中预测框和标记框的重叠程度,其值等于预测框和标记框的交集与二者并集的比值。文献[22]中IOU的选取方式为IOU>0.7或者IOU最大的候选区域认定它存在硅藻目标,IOU < 0.3则分为背景,IOU在0.3~0.7中间的候选区域不予考虑且IOU的计算仅存在于训练过程用于训练softmax分类器;另一部分通过边框回归计算硅藻目标区域的边框回归的偏移量并且去掉一部分太小或者超出边界的候选区域,初步完成目标定位,以便于后续过程中获得硅藻目标精确的位置信息,RPN流程图如图 3所示。

|

图 3 本文算法中RPN网络流程图 Fig.3 RPN network flow chart in the algorithm of this paper. |

Fast R-CNN模块用来提取硅藻目标区域特征进行分类识别以及定位的深度卷积神经网络模型,其作用是对RPN中产生的硅藻目标区域中的目标进行识别并且精修该区域中目标的位置信息。该模块主要由四部分组成:卷积层:在这部分硅藻图像和卷积核做卷积运算,生成特征图像;ROI Pooling:将不同维度的硅藻目标区域特征变成统一维度的特征送入后续步骤,这部分功能的加入使得网络的输入可以是任意尺度的图像,而不是固定大小的输入,有效避免了对图像进行放缩而导致图像发生畸变;Classification:将经过ROI Pooling之后的硅藻目标区域特征作为输入,输出该区域中硅藻目标的种属鉴定结果;Regression:对输入的硅藻目标区域再次进行边框回归,得到更加精确的目标位置信息。

1.4 Faster R-CNN损失函数| $ \begin{align} & L\left( \left\{ {{p}_{i}} \right\}, \left\{ {{t}_{i}} \right\} \right)=\frac{1}{{{N}_{cls}}}\sum\limits_{i}{{{L}_{cls}}\left( {{p}_{i}}, p_{i}^{*} \right)} \\ & \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ +l\frac{1}{{{N}_{reg}}}\sum\limits_{i}{p_{i}^{*}{{L}_{reg}}\left( {{t}_{i}}, t_{i}^{*} \right)} \\ \end{align} $ | (9) |

| $ {{L}_{cls}}\left( {{p}_{i}}, p_{i}^{*} \right)=-\log \left[ p_{i}^{*}{{p}_{i}}+\left( 1-p_{i}^{*} \right)\left( 1-{{p}_{i}} \right) \right] $ | (10) |

| $ {{L}_{reg}}\left( {{t}_{i}}, t_{i}^{*} \right)=R\left( {{t}_{i}}-t_{i}^{*} \right) $ | (11) |

| $ smoo\ \text{t}{{\text{h}}_{L1}}\left( x \right)=\left\{ \begin{matrix} 0.5{{x}^{2}} & if\left| x \right|<1 \\ \left| x \right|-0.5 & o\ \text{th}\ erwise \\ \end{matrix} \right\} $ | (12) |

其中,i表示一个mini-batch中候选区域的索引,Ncls表示mini-batch中输入区域样本的个数,Nreg表示输入的所有参考区域的个数,λ用于平衡两部分比重, 默认取值为10以维持cls和reg的值基本相同,并且在文献[8]中作者通过实验证明λ在1~100以内对mAP的值没有太大的影响。损失函数由分类和边框回归两部分组成,Lcls表示分类损失函数,其中pi*表示第i个区域的真实标签,pi表示anchor作为对象的预测标签。Lreg表示边框回归损失函数,其中R是smoothL1函数,对于每一个anchor,计算完回归损失之后需要再计算和pi*的乘积,因此ti*是一个向量,表示真值区域的4个参数化坐标,ti表示预测的候选区的4个参数化坐标。

2 数据集制作 2.1 硅藻图像数据来源本文中实验图像由刑事科技部门提供,图像从采集到成像需要经过以下几个步骤。

(1) 剖室检材提取:对尸体进行解剖,从尸体中提取肾脏、肝右叶以及左肺上叶组织样本;(2)实验室检材提取:清晰样本后,取小部分深度组织于试管中;(3)微波消解;(4)真空抽滤;(5)扫描电镜能谱仪分析:在扫描电镜分析程序中,选择滤膜圆心处为中心,在一定焦距下划分视场,调好焦距,运行能谱仪的图像自动采集程序,待所有视场的图像采集完后,以人工方式对每个市场图像上的硅藻进行搜寻,并回访感兴趣现场,在高倍数下拍摄硅藻高分辨率电镜扫描图像。

2.2 数据集设置由于没有复杂背景下硅藻图像的公共数据集,因此本文中使用采集到的图像组成自建图像库并使用该数据集来完成实验。本文中数据集由3部分组成,数据集A、B用于研究机器学习算法在背景由简单逐渐变为复杂时的识别效果,数据集C用于验证深度学习算法在复杂背景下对于法医学检验中常见的8种硅藻的识别效果。具体如下:

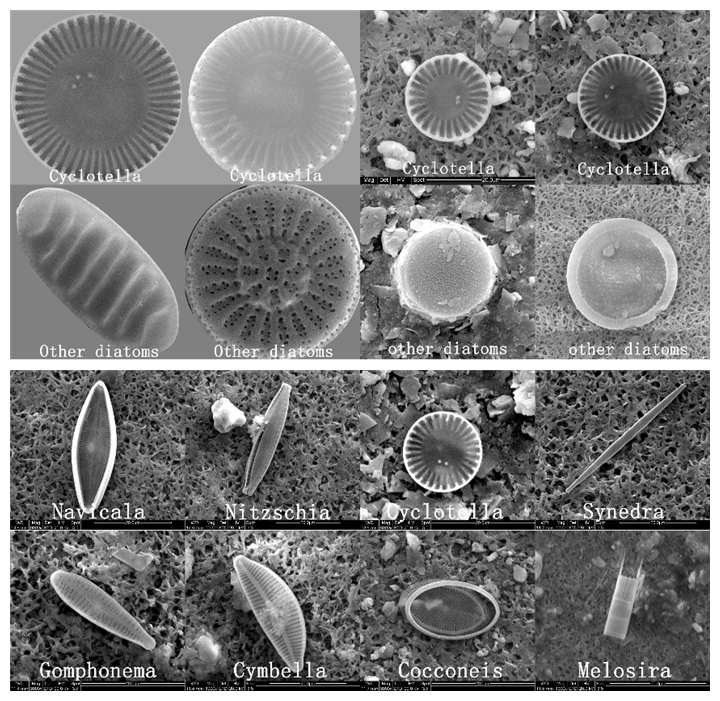

2.2.1 数据集A:简单背景下的小环藻及非小环藻图像数据集该数据集中含有小环藻200张,非小环藻100张,共计300张图像,将其3/4用来制作训练集以训练分类器,1/4用来制作测试集来测试算法性能。数据集中的示例图像如图 4A所示。

|

图 4 数据集中图像示例 Fig.4 Representative images in datasets A, B, and C. |

该数据集图像预处理过程较为复杂,首先找出图像中硅藻目标的最小外接圆,将圆中的目标放置于图像中心且圆的直径设为500,然后将图像裁剪为1000×1000大小。该数据集中含有小环藻和非小环藻50张,其中3/4用于制作训练集,1/4用于制作测试集,在图像中包含大量背景干扰,示例图像如图 4B所示。

2.2.3 数据集C法医学检验中的常见的八种复杂背景下的硅藻图像,是采集到的未经预处理的硅藻图像。

该数据集中含有八种不同的硅藻,其中小环藻400张、舟形藻400张、菱形藻400张、针杆藻280张、异极藻220张、桥弯藻346张、卵形藻160张、直链藻400张,因为该数据集中图像采集难度较大,因此个别种类采集到的图像数量相差较大。为了将尽量多的图像用于训练过程,该数据集中的测试图像较少,仅包含8个种类的图像共76张,目标共81个。数据集中所用图像均为500×500大小,其中复杂背景面积较大,示例图像如图 4C所示。数据集分别针对Faster R-CNN算法封装成pascal voc2007数据格式,制作过程中使用LabelImage软件对图像进行标注。

3 结果 3.1 实验环境搭建本文中实验分为两大部分,第1部分实验环境为Windows 10操作系统,Intel Core i5- 4210H CPU,NVIDIA965 M显卡,显存2 GB,实验过程中使用的软件是Matlab 2014 b;第2部分实验环境为Intel Core i7- 8700k 3.70 GHZ 12核CPU,NVIDIA 1080 ti显卡,显存11 GB,内存16 GB,在Ubuntu16.04LTS系统上配置了Caffe开源深度学习框架以及使用Python编程语言的py-faster-rcnn算法。

3.2 传统机器学习方法的硅藻识别与定位本文中使用3种机器学习算法进行对比实验,赤潮藻类流式图像自动分析算法研究[6],词包模型在藻类分类识别中的应用[7],复杂背景下高分辨率电镜的小环藻识别[8],3种算法在数据集A中的识别精度分别为:93%、72%、85%,在数据集B中的识别精度分别为:64%,60%,60%。从实验结果可以看出,随着背景的复杂程度增加,传统方法的识别率显著下降,例如文献[6]中算法识别率从93%下降到64%。

3.3 深度学习算法的硅藻识别与定位本文应用Faster R-CNN算法来对复杂背景下的硅藻图像中的硅藻目标进行识别以及定位。深度学习算法需要的数据量较大,因此本文中使用数据集C来完成深度学习部分的实验。

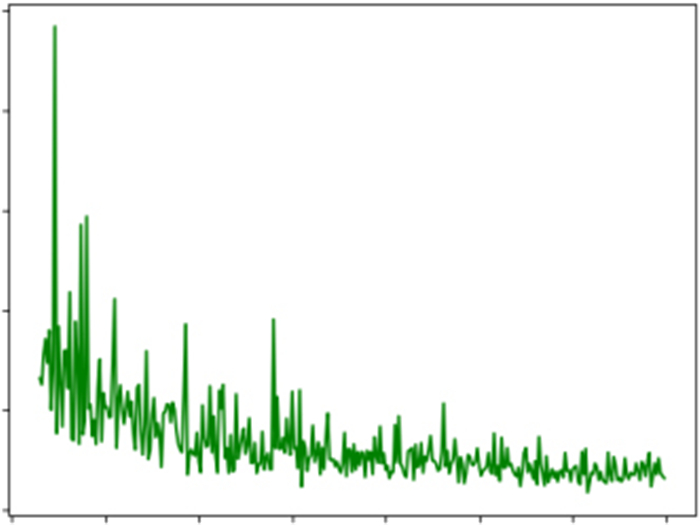

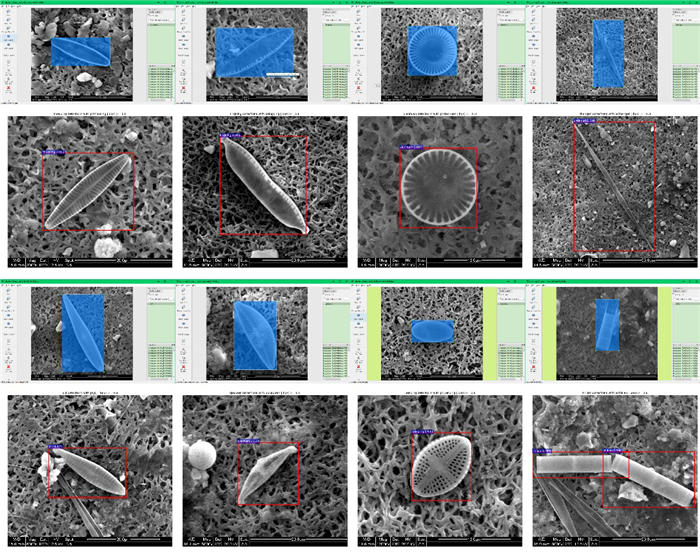

这部分实验中使用端到端训练方式,ZFNet[17]作为基础特征提取网络,训练过程中参数设置为:iter=70 000,gamma=0.1,stepsize=50 000,display=20,average_loss= 100。如图 5所示,经过人为统计测试集中目标数量以及检测结果中的目标数量并且计算Accuracy值,在损失函数已经收敛时Faster R-CNN得到的Accuracy= 0.852,mAP=0.8651。其标记过程以及正确测试结果对比示例如图 6所示,错误识别的图像如图 7所示。

|

图 5 Faster R-CNN算法的loss-iteration曲线图 Fig.5 Loss-iteration graph of Faster R-CNN. |

|

图 6 八种硅藻图像标记过程以及测试结果对比 Fig.6 Labeling process and comparison of test results on eight diatom images. The blue rectangles represent the diatom regions labeled by experts, and the red ones represent the diatom regions labeled by the proposed algorithm. The training and test images are from the different datasets. |

|

图 7 错误识别图像示例 Fig.7 Example of misrecognition images. A: Gomphonema algae is incorrectly recognized as Navicula; B: Cymbella is repeatedly recognized as Nitzschia; C: Gomphonema is misrecognized as Cymbella. |

当前,人们虽然已经提出了很多方法用于识别藻类目标,但是这些算法主要都是针对于水中采样的简单背景下的藻类目标且仅用于识别任务。鲜有针对医学检验中需要用到的复杂背景的硅藻目标检测算法,本文建立了不同复杂背景下的硅藻图像自建库,使用该数据集验证了几种传统机器学习算法对于复杂背景下的硅藻目标的识别效果,在种类较少、图像背景变的复杂时,机器学习算法的识别精度大幅下降,不能用于复杂背景下硅藻图像的识别与定位。想要在大量复杂背景下克服干扰,并且在图像的数量和种类都增加时还能够精确的识别硅藻目标,就需要寻找鲁棒性更好、精度更高的算法。

因此,本文提出了使用Faster R-CNN算法来对法医学检验中常见的八种硅藻目标进行识别以及检测的算法。深度学习中使用了八种共计2606张硅藻图像用于训练以及76张图像用于测试。在实际应用中,Accuracy值高于70%即可应用与法医学中的鉴定,经过实验证明该算法能够有效的对复杂背景下的硅藻目标进行识别并且定位,具有良好的抗干扰性。这是因为相较于使用传统机器学习来识别硅藻图像的算法,本文中提出算法具有以下优点:

(1) RPN与Fast R-CNN共享卷积层RPN具有尺度和旋转不变性,相对于滑窗策略能够极大减少用于产生候选区域的时间开销并且能够更好的解决不同种类硅藻尺度、形状不同,难以识别的问题。

(2) Faster R-CNN使用CNN提取图像特征,其优点在于不会让特征成为提高准确率的瓶颈,可以利用不同的卷积层、池化层和最后输出的特征向量的大小控制整体模型的拟合能力。硅藻图像经过多次卷积之后能够生成具有代表性的高层次硅藻目标特征,有效避免了人为设计的特征集因为不同硅藻的纹理、形状方面的差异而产生错误的识别结果。

该实验中虽然在数据集中复杂背景硅藻图像种类增多的情况下取得了比传统机器学习算法更好的识别结果,但是仍然存在一些需要改进的问题。主要问题是由于难以采集到足够的图片,因此训练以及测试用的数据集图片数据量不多并且数量不均衡,导致算法对于数据集中图像数量太少且外形相似的藻类目标检测效果一般。在后续的工作中我们会继续采集到更多的硅藻以及使用数据增强方法来扩充硅藻图像数据集。针对小目标的检测效果不是特别理想的问题,拟采用特征融合方法来增强算法对于小目标的敏感度,并且会尝试使用不同的基础CNN网络来提升硅藻目标的检测效果。

| [1] |

孙丞辉, 王彪, 李正东, 等. 溺水尸体硅藻检验的研究进展[J]. 法医学杂志, 2015, 31(6): 462-5. DOI:10.3969/j.issn.1004-5619.2015.06.012 |

| [2] |

陈光辉, 孙建. 硅藻检验在水中尸体法医学鉴定中的应用[J]. 广东公安科技, 2014, 22(3): 71-3. |

| [3] |

刘向东, 徐曲毅, 刘超. 基于DNA条形码的硅藻检验在溺死诊断中的研究进展[J]. 广东公安科技, 2018, 132(2): 14-6. |

| [4] |

Chang L, Duarte MM, Sucar LE, et al. A Bayesian approach for object classification based on clusters of SIFT local features[J]. Expert Systems With Applications, 2012, 39(2): 1679-86. |

| [5] |

Verikas A, Gelzinis A, Bacauskiene M, et al. Phase congruencybased detection of circular objects applied to analysis of phytoplankton images[J]. Pattern Recognition, 2012, 45(4): 1659-70. DOI:10.1016/j.patcog.2011.10.019 |

| [6] |

谢杰镇, 骆庭伟, 戴君伟, 等. 赤潮藻类流式图像自动分析算法的研究[J]. 计算机科学, 2013, 40(7): 293-6. DOI:10.3969/j.issn.1002-137X.2013.07.066 |

| [7] |

张松, 周亚丽, 张奇志. 词包模型在藻类分类识别中的应用[J]. 北京信息科技大学学报:自然科学版, 2016, 109(1): 31-5. |

| [8] |

邓杰航, 王晓宇, 赵建, 等. 复杂背景下高分辨率电镜的小环藻识别[J]. 计算机工程与设计, 2019, 40(1): 175-80. |

| [9] |

García-Floriano A, Ferreira-Santiago Á, Camacho-Nieto O, et al. A machine learning approach to medical image classification: Detecting age- related macular degeneration in fundus images[J]. Computers Electri Engineering, 2019, 75: 218-29. DOI:10.1016/j.compeleceng.2017.11.008 |

| [10] |

Cao LJ, Chong WK. Feature extraction in support vector machine: a comparison of PCA, XPCA and ICA[C]//Proceedings of the 9th International Conference on Neural Information Processing, 2002, 2: 1001-5.

|

| [11] |

Ojala T, Pietikainen M, Maenpaa T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[J]. IEEE Transactions on pattern analysis and machine intelligence, 2002, 24(7): 971-87. DOI:10.1109/TPAMI.2002.1017623 |

| [12] |

Soh LK, Tsatsoulis C. Texture analysis of SAR sea ice imagery using gray level co-occurrence matrices[J]. IEEE Transactions on geoscience and remote sensing, 1999, 37(2): 780-95. DOI:10.1109/36.752194 |

| [13] |

Chang CC, Lin CJ. LIBSVM: A library for support vector machines[J]. ACM transactions on intelligent systems and technology (TIST), 2011, 2(3): 1-27. |

| [14] |

Huang C, Davis LS, Townshend JRG. An assessment of support vector machines for land cover classification[J]. International J Remote sens, 2002, 23(4): 725-49. DOI:10.1080/01431160110040323 |

| [15] |

LeCun Y, Bengio Y, Hinton G. Deep learning[J]. Nature, 2015, 521(7553): 436-44. DOI:10.1038/nature14539 |

| [16] |

Krizhevsky A, Sutskever I, Hinton GE. Imagenet classification with deep convolutional neural networks[C]//Advances in neural information processing systems. 2012: 1097-105.

|

| [17] |

Zeiler MD, Fergus R. Visualizing and understanding convolutional networks[C]//European conference on computer vision. Springer, Cham, 2014: 818-33.

|

| [18] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv:1409.1556, 2014. |

| [19] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2014: 580-7.

|

| [20] |

He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1904-1916. DOI:10.1109/TPAMI.2015.2389824 |

| [21] |

Girshick R. Fast r-cnn[C]//Proceedings of the IEEE international conference on computer vision, 2015: 1440-8.

|

| [22] |

Ren S, He K, Girshick R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[C]//Advances in neural information processing systems, 2015: 91-99.

|

| [23] |

Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition, 2016: 779- 88.

|

| [24] |

Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]//European conference on computer vision. Springer, Cham, 2016: 21-37.

|

| [25] |

Chen X, Xiang S, Liu CL, et al. Vehicle detection in satellite images by hybrid deep convolutional neural networks[J]. IEEE Geoscience and remote sensing letters, 2014, 11(10): 1797-801. DOI:10.1109/LGRS.2014.2309695 |

| [26] |

Jaderberg M, Simonyan K, Vedaldi A, et al. Reading text in the wild with convolutional neural networks[J]. Internation J Computer Vision, 2016, 116(1): 1-20. |

| [27] |

Liao Y, Lu X, Zhang C, et al. Mutual enhancement for detection of multiple logos in sports videos[C]//Proceedings of the IEEE International Conference on Computer Vision, 2017: 4846-55.

|

| [28] |

Pedraza A, Bueno G, Deniz O, et al. Automated diatom classification (Part B): a deep learning approach[J]. Applied Sciences, 2017, 7(5): 460. DOI:10.3390/app7050460 |

| [29] |

Pedraza A, Bueno G, Deniz O, et al. Lights and pitfalls of convolutional neural networks for diatom identification[C]//Optics, Photonics, and Digital Technologies for Imaging Applications V. International Society for Optics and Photonics, 2018, 10679: 106790G.

|

| [30] |

Fang W, Ding L, Zhong B, et al. Automated detection of workers and heavy equipment on construction sites: A convolutional neural network approach[J]. Advanced Engineering Informatics, 2018, 37(8): 139-49. |

| [31] |

Hinton GE, Srivastava N, Krizhevsky A, et al. Improving neural networks by preventing co-adaptation of feature detectors[J]. arXiv preprint arXiv: 1207.0580, 2012.

|

| [32] |

Gardner WA. Learning characteristics of stochastic-gradient-descent algorithms: A general study, analysis, and critique[J]. Signal Processing, 1984, 6(2): 113-33. DOI:10.1016/0165-1684(84)90013-6 |

2020, Vol. 40

2020, Vol. 40