生物特征识别是对人体自身所拥有的生理或行为特征进行身份识别[1-2]。人体的手掌静脉[3](以下简称"掌脉")具有唯一性, 稳定性, 隐藏在表皮下, 结构复杂, 很难被复制, 相对于掌纹[4]、指纹[5], 不易受脱皮等外部环境的影响, 相对于手背[6]、手指静脉[7], 图像信息更加丰富, 是一种高安全性的生物特征。掌脉识别可被广泛应用到门禁系统、考勤系统、教育金融等领域, 是一种有着广泛应用前景的生物特征识别技术[8]。近些年来, 一些研究者对于掌脉特征提取与识别方法开展了研究, 大致可以分为3类:(1)基于结构特征的方法, 如通过尺度不变特征变换(SIFT)[9]提取掌脉点特征进行识别; (1)基于子空间的方法, 如应用双方向的二维线性判别分析(2D)2 LDA[10]、主成分分析法(PCA)[11]将图像投影或变换到一个低维空间进行表示和匹配; (3)基于纹理特征的方法, 如采用局部二值模式(LBP)[12]、GaussianRandon[13]、Gabor滤波器[14]等方法提取掌脉纹理信息, 然后编码进行匹配识别。

上述传统掌脉识别方法虽然可以获得一个相对较好的结果, 但也有不足:(1)需要一组与特定环境相关的实验参量, 当手掌的姿态、大小和光照条件发生变化时, 方法的稳健性较差; (2)需要根据图像本身特点和研究人员的经验人工设计算法提取特征, 人工设计的特征通常只是掌脉图像的浅层特征, 表达能力有限; (3)将特征提取和特征匹配分步进行, 使特征提取缺乏匹配结果的指导, 在掌静脉信息不足的情况下, 不能充分提取有效信息。卷积神经网络(CNN)方法具有很强的图像表达能力, 已经成功应用于场景分类[15-16]、目标检测[17-18]、图像检索[19-20]、人脸识别[21-22]中, 能够同时进行特征提取和分类识别, 并且识别结果会反向作用于特征提取, 不需要人工设计特征。但是, 由于该方法学习能力比较强, 能够在输入与输出之间表达复杂的非线性关系, 容易出现网络过拟合问题。

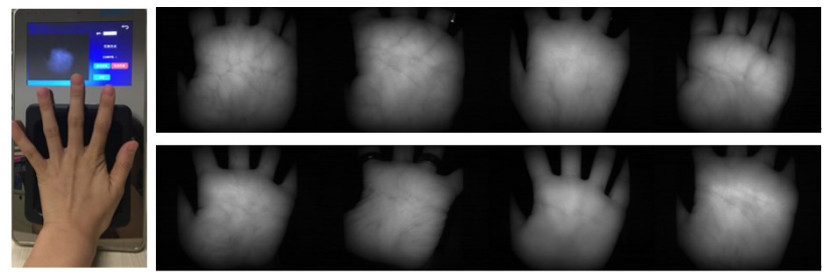

针对上述问题, 本文提出一种针对手掌静脉识别的端到端卷积神经网络模型(以下简称"掌静脉识别网络模型"), 利用基于动量加速的随机梯度下降法训练网络, 采用L2参数正则化、Dropout、批归一化(BNorm)、训练集数据扩展四种方法提升网络的泛化能力。由于公开的PolyU数据库[23]图像主要是在高约束(手指、手掌固定)条件下获取的, 图像比较清晰, 静脉信息较丰富, 旋转、平移、比例缩放等形变微小, 可能会导致掌脉识别性能很好却实用性不足。为此, 我们建立一个新的掌脉数据库(以下简称"自建库"), 包含500个手掌共4191幅图像, 所有图像均在自然环境下采集, 更加符合实际应用的需求, 采集设备及其采集到的图像如图 1所示, 由于不同的人手掌的大小、姿态、物理结构不一样, 不同时间段的采集环境不一样, 采集的图像质量参差不齐, 主要表现为昏暗不一、噪声含量较高、部分静脉信息丢失、甚至还产生一定程度的形变。本文分别采用PolyU库和自建库的掌脉图像验证提出的方法, 并且通过与其它高性能方法进行比较来突出本文方法在实际环境中的使用优势。

|

图 1 掌脉图像采集设备及其采集到的图像示例 Fig.1 An example of the equipment for palm vein image acquisition and the acquired images. |

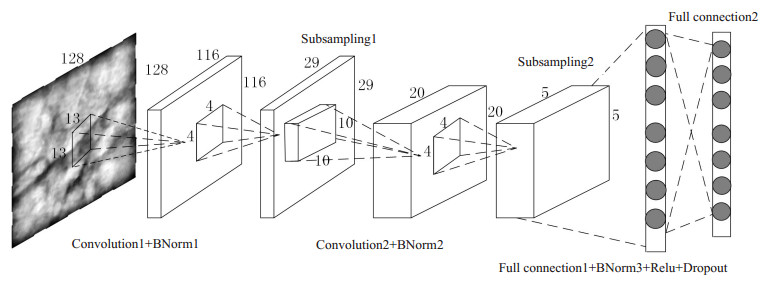

本文提出的基于端到端CNN的掌静脉识别网络模型结构如图 2所示, 包括2个卷积层、2个池化层、3个批归一化层、1个激活层、1个Dropout层和2个全连接层。输入层为经过简单预处理的输入图像, 一般不计入网络的层次中, 卷积层与池化层交替连接形成一个特征提取器提取输入图像的特征。最后的2个全连接层构成一个神经网络(NN)分类器, 完成分类任务。模型的损失函数为softmax log-loss, 整个网络可以看成是由损失函数监督的卷积特征学习的自动分类识别机器。

|

图 2 掌静脉识别网络模型结构 Fig.2 Architecture of palm vein recognition network model. |

卷积层是网络的核心结构。该层的每个神经元与前一层局部连接, 连接的权值矩阵称为卷积核或者滤波器, 卷积核以步长s通过"滑动窗口"的方式提取输入图像不同位置的特征, 输出一个特征图。一个特征图对应一个卷积核, 即该特征图的每个神经元的权值是共享的。但不同的特征图提取的特征是不相同的。数学表达式为:

| $ {x^l} = \sum\limits_{k = 1}^r {x_k^{l - 1}\Theta W_k^l} + {b^l} $ | (1) |

其中:r是前一层的特征图个数; l表示当前层数; Θ表示卷积运算; Wkl表示权重(卷积核), bl表示偏置。此外, 输出特征图的大小so与输入数据的大小si、卷积核的大小sk、卷积核的步长s有关, 其数学表达式为:

| $ {s_o} = \frac{{{s_i} - {s_k} + 1}}{s} $ | (2) |

卷积核是模拟视觉系统中的感受野, 卷积核的大小对应感受野的大小, 卷积核的方向对应感受野轴突的方向。不同卷积核方向提取不同方向的特征, 第一个卷积层提取诸如边缘或线条等的简单特征。由于输出特征图的大小随着卷积神经网络的深度增加而减少, 为了保证在传递过程中图像的特征信息不缺失, 输出特征图的个数应该逐层增加, 使得在传递中信息量(输出特征图的大小乘以个数)是非递减的。虽然在网络的低层次中只提取简单特征, 但随着网络层次的增加, 高层的每个神经元感受到的是不断增加的低层区域, 即低层提取的那些简单特征在高层中不断汇合组成复杂特征, 最后获得全局特征信息。

1.2 池化层池化层是模拟复杂细胞将低级的视觉特征筛选并结合成更高级、抽象的视觉特征的过程, 在网络中具体表现为对卷积层输出的不同位置的特征信息进行聚合, 也就是下采样操作。常见的采样方式有平均采样、最大值采样、平方和开根号采样。通过池化层的采样后, 特征图数目不改变, 尺寸会变小, 分辨率会降低、同时也减少了计算复杂度、增加对平移、旋转、缩放的鲁棒性。本文采用最大值采样, 采样大小为4×4, 即用4×4大小的窗口不重叠通过整个输入的特征图, 选取每个窗口内的最大值作为输出值, 因此输出特征图的长和宽均是输入特征图的四分之一。该层的数学表达式为:

| $ {y^{\left( l \right)}} = down\left( {{y^{\left( {l - 1} \right)}}} \right) $ | (3) |

其中:down表示最大值采样的函数。

1.3 全连接层全连接层的每个神经元与输入特征图的所有神经元相连, 由于输入特征图的维数已经降低到很小, 即使是全连接也不会导致严重的计算负担。本文提出的掌静脉识别网络模型最后2层为全连接层, 是一个NN分类器。第一个全连接层输出属于每个识别样本的特征向量:

| $ x_j^l\sum\limits_{i = 1}^n {x_i^{l - 1} \cdot w_{ji}^l} + b_j^l $ | (4) |

其中:n是前一层的神经元个数; l表示当前层数; wjil是该层神经元j与前一层神经元i的连接强度; bjl是该层神经元j的偏置。第二个全连接层输出该样本属于每一类的得分向量:

| $ x_j^{l + 1}\sum\limits_{i = 1}^n {x_i^{l - 1} \cdot w_{ji}^{l + 1}} + b_j^{l + 1} $ | (5) |

对每个样本的最大得分值与其真实标签所在类的得分值进行比较, 来表示本文的损失函数, 数学表达式为:

| $ L = - \frac{1}{m}\sum\limits_k^{} {\log \left( {\frac{{e\left( {x_c^k - x\max } \right)}}{{\sum\limits_{i = 1}^n {e\left( {x_i^k - x\max } \right)} }}} \right)} $ | (6) |

其中:n表示最后一层神经元个数, 即类别总数; m表示样本总数, k=1, ..., m; x max表示该样本的最大得分值; xck表示该样本所在类的得分输出值, 即真实标签所在类的得分值; xik表示样本k属于第i类的得分值。

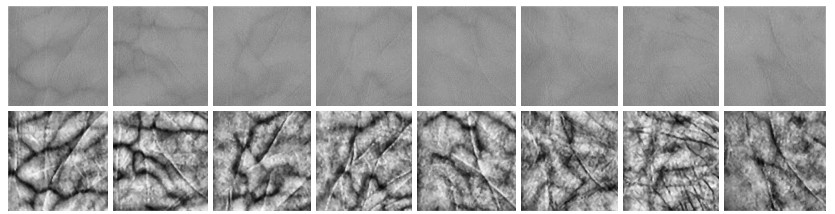

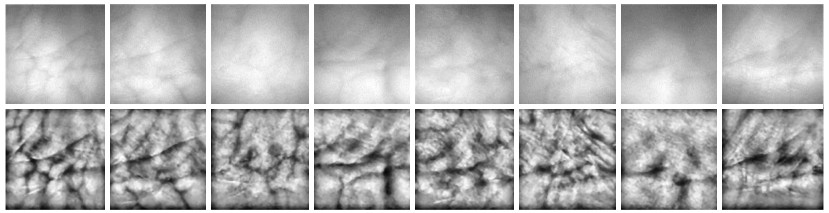

2 网络训练 2.1 数据预处理PolyU库图像是对195名男性和55名女性分两次采集得到的, 对于一个手掌第一次采集6幅掌脉图像, 间隔9 d, 再采集6幅图像。该数据库共有500个手掌, 6000幅图像。自建库图像也是对250个人的左手和右手分别采集, 对于一个手掌采集的图像个数有6幅、8幅、9幅、10幅、12幅不等, 该库500个手掌包含4191幅图像。由于人的左手和右手静脉血管分布完全不同, 这500个不同的手掌可以看作是500类。图 3是PolyU库掌脉样例, 图 4是自建库掌脉样例, 从左到右分别与图 1中的手掌对应。本文采用文献[24-25]中的方法对ROI图像进行增强。相比PolyU库的掌脉图像, 自建库的图像静脉信息量较少, 清晰度较低, 有一些甚至产生平移、旋转、内凹、外凸变化, 识别难度增大。本文对两个库的数据同做以下处理:

|

图 3 PolyU库手掌静脉样例 Fig.3 Representative images from PolyU database. Upper row:ROI in the original images; lower row:Enhanced images. |

|

图 4 自建库手掌静脉样例 Fig.4 Representative images from the self-established database. Upper row:ROI in the original images; lower row:Enhanced images. |

(1) 对图像进行归一化处理, 将每个图像减去训练集的均值图像。

(2) 对于每个手掌, 随机选取其3幅图像作为训练集数据, 2幅图像作为验证集数据, 剩下的作为测试集数据。

2.2 网络训练算法掌静脉识别网络的训练过程可以看成是代价函数监督的卷积特征学习过程, 就是通过代价函数减小的方向来优化调整神经元之间的连接权和偏置。

由于代价函数是非凸的, 存在很多局部极小值点, 训练中模型易陷入局部最优。本文采用基于动量加速[26]的随机梯度下降法[27]。与标准梯度下降法精确计算梯度不同, 随机梯度下降法在计算梯度时加入随机因素, 每次迭代时求出的梯度不一定指向代价函数变化率最大的方向, 即使陷入局部极小点, 计算出的梯度仍可能不为零, 这样就有机会跳出局部极小, 继续搜索使代价函数降低的参数值。

对于PolyU库的训练, 批处理块的大小为100, 动量为0.9, 学习速率为0.01。对于自建库的训练, 训练和验证集的批处理块大小为100, 测试集的批处理块大小为89, 动量为0.985, 学习速率为0.01。

本文提出的掌静脉识别网络模型包含多个非线性隐层, 能够在输入与输出之间表达复杂的非线性关系, 学习能力比较强, 易出现过拟合现象。针对这个问题, 本文采用如下4个方法解决:

(1) 训练集数据扩展

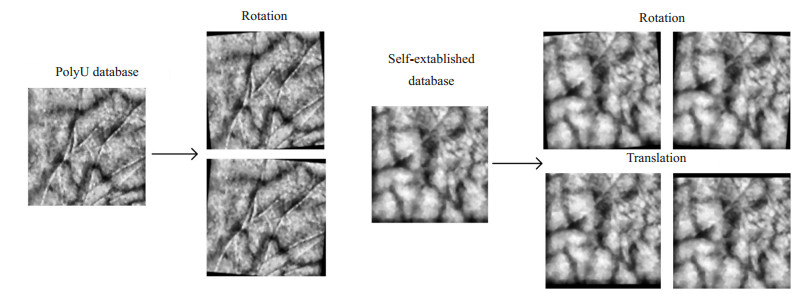

在训练样本数据不足的情况下, 很容易出现在训练集上效果很好, 测试集上效果一般的情况。由于图像是高维的并且包含各种变化因素, 其中很多因素是可以轻易地模拟的。本文对训练数据进行扩展, 将PolyU库的所有训练数据旋转正负5度, 训练样本变为原来的3倍。将自建库的所有训练数据旋转正负5度, 上下平移5个像素单位, 训练样本变为原来的5倍(图 5)。

|

图 5 训练集数据的扩展 Fig.5 Augmentation of the training set data. |

(2) L2参数正则化

L2参数正则化是最简单、最常见的参数范数惩罚, 通常被称为权重衰减。通过向损失函数添加一个正则项

| $ L = - \frac{1}{m}\sum\limits_k {\log \left( {\frac{{e\left( {x_c^k - x\max } \right)}}{{\sum\limits_{i = 1}^n {e\left( {x_i^k - x\max } \right)} }}} \right) + \frac{\lambda }{2}\left\| w \right\|_2^2} $ | (7) |

其中:λ是正则化系数, 对于PolyU库和自建库, 本文的λ取值分别为0.0005和0.0009。

(3) Dropout

为了使代价函数减小到最低, 各神经元之间建立了复杂的相互适应, 即一部分神经元参数值的改变是为了弥补其它神经元带来的误差损失, 然而这种相互适应不能泛化到未知的数据, 就会产生过拟合。Dropout[28]能够打破这种相互适应, 即在网络的训练阶段, 以一定的概率将输入层或隐层的神经元置为0, 使其不参与网络的前向传播和误差反向传播, 相当于不是网络的一部分。但是在网络的测试阶段, 所有神经元都被激活, 参与网络的传播, 只是权重减小为原来的p倍, 即wtest(l)=pw(l)。

(4) BNorm

在训练网络时, 每一层输入值分布的改变, 都会使网络训练变得复杂且缓慢。本文对两个卷积层和第一个全连接层的输出进行BNorm[29]处理来加速网络的训练, 提升网络的泛化能力, 批归一化层不改变特征图的大小和数量。

3 实验结果本文采用大小为128×128的ROI增强图像进行实验, 网络的初始权重服从均值为0, 标准差为0.01的高斯分布, 两个卷积层中卷积核的大小分别为13×13, 10× 10, 卷积核步长都为1, 两个池化层采用最大值池化, 采样大小为4×4, 采样步长为4, 激活函数采用Rectified Linear Units (ReLU)[30]。

本文的网络模型可简约描述为"a-b-c", a表示第一个卷积层的特征图数量, b表示第二个卷积层的特征图数量, c表示第一个全连接层的神经元个数, 第二个全连接层的神经元个数与网络的分类个数相同。本文分别改变全连接层的神经元个数和两个卷积层的特征图个数, 找出最适合这两个掌脉数据库的网络模型, 并且通过实验说明不同正则化项对网络的影响。

采用3个数据集的正确识别率评估实验结果, 训练集识别率表示网络是否训练好, 验证集识别率可以及时判断网络是否收敛, 根据训练集和验证集识别率曲线的拟合程度, 调节相应的参数, 测试集识别率表示网络的泛化能力。

实验的运行环境主要是基于Windows 7旗舰版下的Matlab R2015b, 并且在某些功能函数上采用C++ (Microsoft Visual Studio 2013)和Matlab混合编程来加速程序的运行, 减少模型的训练耗时, CPU为3.3 GHz的Intel (R) Core (TM) i5-4590, 内存为4 GB。

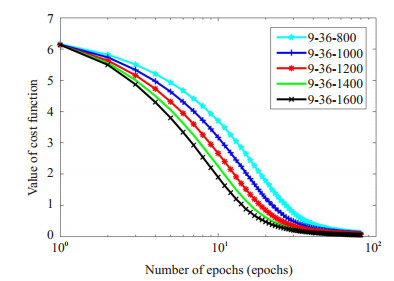

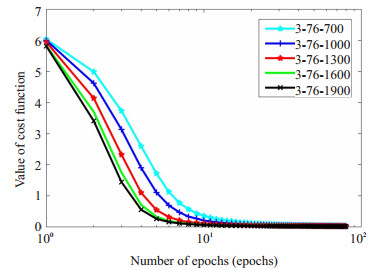

3.1 全连接层神经元个数改变对网络的影响本文采用9-36-800, 9-36-1000, 9-36-1200, 9-36- 1400, 9-36-1600模型测试PolyU库, 用3-76-700, 3-76- 1000, 3-76-1300, 3-76-1600, 3-76-1900模型测试自建库。图 6和图 7分别描述了这两个库在不同模型下每次迭代对应的代价函数值, 随着迭代次数的增加, 代价函数逐次减少, PolyU库的代价函数在60到80次的迭代过程中趋于平稳, 选取迭代次数为80, 测量各个模型对于该数据库的训练集、验证集、测试集的识别率, 结果如表 1所示。自建库的代价函数在20到80次的迭代过程中趋于水平, 由于自建库的图像质量参差不齐, 波动较大, 增加迭代次数可以改善网络泛化能力, 所以选取迭代次数为80次, 测量各个模型对于该数据库的训练集、验证集、测试集的识别率(表 2)。本文所有的识别率都是指得分最大值所在的类与真实类匹配的概率。

|

图 6 PolyU库训练的不同CNN模型的代价函数值 Fig.6 Cost function value of the CNN models trained with PolyU database. |

|

图 7 自建库训练的不同CNN模型的代价函数值 Fig.7 Cost function value of the CNN models trained with the self-established database. |

| 表 1 全连接层神经元个数改变对应PolyU库的正确识别率 Tab.1 CRR of PolyU database with varying numbers of neurons in the fully connected layer |

从表 1和表 2可以看出, 对于PolyU库, 全连接层的最佳个数为1000, 对于自建库, 全连接层的最佳个数为1300。

| 表 2 全连接层神经元个数改变对应自建库的正确识别率 Tab.2 CRR of the self-established database with varying numbers of neurons in the fully connected layer |

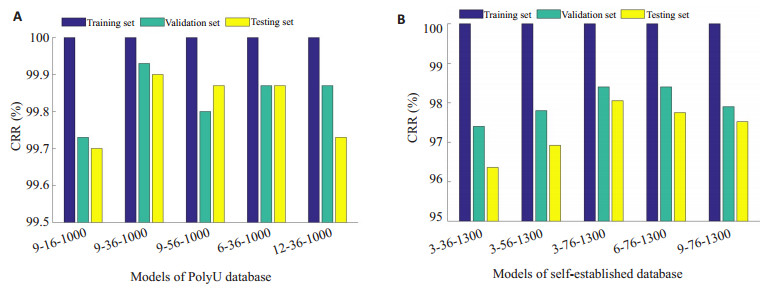

本文用9-16-1000, 9-36-1000, 9-56-1000, 6-36- 1000, 12-36-1000模型测试PolyU库, 用3-36-1300, 3- 56-1300, 3-76-1300, 6-76-1300, 9-76-1300模型测试自建库。结果分别如图 8 (A)和(B)所示。对于PolyU库, 最佳的卷积神经网络模型为9-36-1000。对于自建库, 最佳的卷积神经网络模型为3-76-1300。

|

图 8 两个卷积层特征图个数改变对应PolyU库(A)和自建库(B)的正确识别率 Fig.8 CRR of PolyU database (A) and self-established database (B) with varying numbers of feature maps in convolutional layer. |

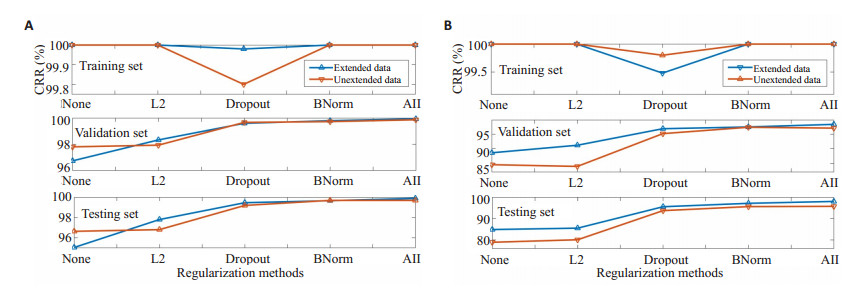

本文采用4种正则化方法解决网络的过拟合问题, 不同正则化方法对PolyU库9-36-1000模型和自建库3- 76-1300模型的影响分别如图 9 (A)和(B)所示。分析实验我们发现:

|

图 9 不同正则化方法对9-36-1000(A)和3-76-1300(B)网络模型的影响 Fig.9 CRR of the 9-36-1000 (A) and 3-76-1300 (B) CNN models for different regularization methods (Top:CRR of training set, middle: CRR of validation set, bottom:CRR of testing set). |

(1) 使用4种正则化方法对网络的泛化能力有很大的提升, 对于PolyU库9-36-1000模型, 测试集准确率从96.63%提升到99.90%;对于自建库3-76-1300模型, 测试集准确率从78.89%提升到98.05%。

(2) 对于PolyU库, 单纯的扩展训练集数据并没有改善网络的泛化能力, 但是结合其它正则化方法就会提升网络的识别率; 而自建库由于图像质量变化比较大, 扩展训练集数据可以很好地改善网络的泛化能力。

(3) 对两个库而言, 无论是否扩展数据, L2参数正则化方法对网络性能的提升是最小的; BNorm对网络性能的提升最大; Dropout方法次之, 且由于其在网络训练时总是随机舍弃一部分神经单元, 会出现网络没有完全训练好的情况。

(4) 在网络训练时, 不同正则化方法对学习率的要求不一样, 与其它项相比, BNorm方法采用较大的学习率。我们逐次加入各个正则化方法, 调节相应的学习率和正则化系数, 最终获得识别率更高、更加稳定的结果。

3.4 本文方法与其它文献方法正确识别率比较文献[13]利用掌脉的方向信息采用GaussianRandon变换从6个方向提取掌脉特征, 对响应方向进行二进制编码, 最后计算汉明距离进行匹配。实验结果表明该方法优于大部分掌脉识别算法, 故对本文方法和文献[13]的方法进行比较(为了公平比较, 每个手掌均选取三幅图像训练, 其余的作为测试)。对于PolyU库的识别, 文献[13]的识别率是100%, 本文是99.90%;而对于自建库的识别, 文献[13]的识别率是94.44%, 与本文(CRR=98.05%)相比, 其识别率下降5.56%。

4 讨论手掌静脉识别是一种有广泛应用前景的生物特征识别技术。由于采集到的图像存在对比度低、噪声含量高、光照不均、平移、旋转、比例缩放等问题, 使得准确的掌静脉信息难以获取, 掌静脉的有效识别仍然是一个有挑战性的问题。

与PolyU库相比, 自建库图像是在实际应用场景中采集的, 图像质量参差不齐, 识别难度增加。尽管如此, 本文提出的方法仍然表现出很高识别性能(98.05% vs 94.44%)。可能是因为传统掌静脉识别方法中, 特征提取和特征匹配相互独立, 特征提取缺乏匹配结果的指导; 人工设计的特征往往是图像的浅层特征, 比较单一, 不具有代表性不能充分的表达静脉信息。而本文基于端到端卷积神经网络方法进行手掌静脉自动识别, 特征是依据识别误差自适应迭代获取的, 是一种任务驱动型的方法, 具有更好的鲁棒性。

对于本文提出的掌静脉网络模型, 在一定范围内增加或减少全连接层的神经元个数或者是两个卷积层的特征图数量对识别率的影响比较小, 网络模型具有一定鲁棒性。

本文采用4种正则化方法(训练集数据扩展、Dropout、L2参数正则化、BNorm)来避免网络模型过拟合, 提升其泛化性能。与其它3种方法相比, 训练集数据扩展大大增加了网络的训练时间, 若其对性能提升不明显, 不建议使用该方法。

本研究提出基于端到端卷积神经网络进行手掌静脉识别, 训练时采用基于动量加速的随机梯度下降法加速网络收敛, 四种正则化方法改进网络性能。实验中对PolyU库和自建库全部500个对象的识别, 识别率分别达到99.90%、98.05%, 单个样本的识别时间均小于9 ms, 为掌静脉识别提供了一种新思路。

| [1] |

卢官明, 李海波, 刘莉. 生物特征识别综述[J].

南京邮电大学学报:自然科学版, 2007, 27(1): 81-8.

|

| [2] |

王蕴红, 谭铁牛. 现代身份鉴别新技术——生物特征识别技术[J].

中国基础科学, 2000, 1(9): 6-12.

|

| [3] |

吴微, 苑玮琦. 手掌静脉图像识别技术综述[J].

中国图象图形学报, 2013, 18(10): 1215-24.

DOI: 10.11834/jig.20131001. |

| [4] |

Kong A, Zhang D, Kamel M. A survey of palmprint recognition[J].

Pattern Recognit, 2009, 42(7): 1408-18.

DOI: 10.1016/j.patcog.2009.01.018. |

| [5] |

Marasco E, Ross A. A survey on antis-poofing schemes for fingerprint recognition systems[J].

ACM Comp Sur, 2015, 47(2): 1-36.

|

| [6] |

Trabelsi RB, Masmoudi AD, Masmoudi DS. Hand vein recognition system with circular difference and statistical directional patterns based on an artificial neural network[J].

Multimed Tools Appl, 2016, 75(2): 687-707.

DOI: 10.1007/s11042-014-2315-5. |

| [7] |

Ahmad Radzi S, Khalil-Hani M, Bakhteri R. Finger-vein biometric identification using convolutional neural network[J].

Turkish J Electr Engineer Comp Sci, 2016, 24(3): 1863-78.

|

| [8] |

宋丹, 黄旭. 生物识别技术及其在金融支付安全领域的应用[J].

信息安全研究, 2016, 2(1): 27-32.

|

| [9] |

Ladoux PO, Rosenberger C, Dorizzi B. Palm vein verification system based on SIFT matching[C]. Int Confer Biometr, Springer, 2009.

https://www.researchgate.net/publication/43107723_Palm_Vein_Verification_System_Based_on_SIFT_Matching

|

| [10] |

Lee YP. Palm vein recognition based on a modified (2D) (2)LDA[J].

Signal Image Video Process, 2015, 9(1): 229-42.

DOI: 10.1007/s11760-013-0425-6. |

| [11] |

Wang JG, Yau WY, Suwandy A, et al. Person recognition by fusing palmprint and palm vein images based on "Laplacianpalm"representation[J].

Pattern Recognit, 2008, 41(5): 1514-27.

|

| [12] |

Lu WJ, Li MN, Zhang L. Palm vein recognition using directional features derived from local binary patterns[J].

Int J Signal Process Image Process Pattern Recognit, 2016, 9(5): 87-98.

|

| [13] |

Zhou YJ, Liu YQ, Feng QJ, et al. Palm-Vein classification based on principal orientation features[J].

PLoS One, 2014, 9(11): e112429.

DOI: 10.1371/journal.pone.0112429. |

| [14] |

Zhang D, Guo ZH, Lu GM, et al. An online system of multispectral palmprint verification[J].

IEEE Trans Instrum Meas, 2010, 59(2): 480-90.

|

| [15] |

Cheng G, Yang CY, Yao XW, et al. When deep learning meets metric learning:remote sensing image scene classification via learning discriminative CNNs[J].

IEEE Trans Geosci Remote Sens, 2018, 56(5): 2811-21.

DOI: 10.1109/TGRS.2017.2783902. |

| [16] |

Wang L, Guo S, Huang W, et al. Knowledge guided disambiguation for large-scale scene classification with multi-resolution CNNs[J].

IEEE Trans Image Process, 2017, 26(4): 2055-68.

DOI: 10.1109/TIP.2017.2675339. |

| [17] |

Ren SQ, He KM, Girshick R, et al. Faster R-CNN:towards RealTime object detection with region proposal networks[J].

IEEE Trans Pattern Anal Mach Intell, 2017, 39(6): 1137-49.

DOI: 10.1109/TPAMI.2016.2577031. |

| [18] |

He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J].

IEEE Trans Pattern Anal Mach Intell, 2015, 37(9): 1904-16.

DOI: 10.1109/TPAMI.2015.2389824. |

| [19] |

Zheng L, Yang Y, Tian Q. SIFT meets CNN:A decade survey of instance retrieval[J].

IEEE Trans Pattern Anal Mach Intell, 2018, 40(5): 1224-44.

DOI: 10.1109/TPAMI.2017.2709749. |

| [20] |

Nakazawa T, Kulkarni DV. Wafer map defect pattern classification and image retrieval using convolutional neural network[J].

IEEE Trans Semicond Manufact, 2018, 31(2): 309-14.

DOI: 10.1109/TSM.2018.2795466. |

| [21] |

Syafeeza AR, Khalilhani M, Liew SS, et al. Convolutional neural network for face recognition with pose and illumination variation[J].

Int J Eng Technol, 2014, 6(1): 44-57.

|

| [22] |

Wu YE, Hassner T, Kim K, et al. Facial landmark detection with tweaked convolutional neural networks[J].

IEEE Trans Pattern Anal Mach Intell, 2018, 40(12): 3067-74.

DOI: 10.1109/TPAMI.2017.2787130. |

| [23] |

PolyU Multispectral Palmprint Database. http://www4.comp.polyu.edu.hk/~biometrics/MultispectralPalmprint/MSP.html

|

| [24] |

Zhou YB, Kumar A. Human identification using Palm-Vein images[J].

IEEE Trans Infor Forens Secur, 2011, 6(4): 1259-74.

DOI: 10.1109/TIFS.2011.2158423. |

| [25] |

周宇佳, 刘娅琴, 杨丰, 等. 基于方向特征的手掌静脉识别[J].

中国图象图形学报, 2014, 19(2): 243-52.

|

| [26] |

Sutskever I, Martens J, Dahl GE, et al. On the importance of initialization and momentum in deep learning[C]//Proceedings of the 30th International Conference on Machine Learning, 28. Georgia, USA, 2013: 1139-47.

http://120.52.51.14/www.cs.toronto.edu/~fritz/absps/momentum.pdf

|

| [27] |

Gardner WA. Learning characteristics of stochastic-gradient-descent algorithms:A general study, analysis, and critique[J].

Signal Process, 1984, 6(2): 113-33.

DOI: 10.1016/0165-1684(84)90013-6. |

| [28] |

Srivastava N, Hinton G, Krizhevsky AA, et al. Dropout:a simple way to prevent neural networks from overfitting[J].

J Machine Learn Res, 2014, 15(1): 1929-58.

|

| [29] |

Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the 32nd International Conference on Machine Learning, 37. Lille, France, 2015: 448-56.

https://arxiv.org/pdf/1502.03167v3.pdf

|

| [30] |

Wang P, Ge RQ, Xiao X, et al. Rectified-Linear-Unit-Based deep learning for biomedical multi-label data[J].

Interdiscip Sci, 2017, 9(3): 419-22.

DOI: 10.1007/s12539-016-0196-1. |

2019, Vol. 39

2019, Vol. 39