2. 南方医科大学 南方医院卫生经济管理科,广东 广州 510515

2. Department of Economic Management, Nanfang Hospital, Southern Medical University, Guangzhou 510515, China

在医学研究中,经常需要对不同测量者或测量方法进行一致性评价,其中对于二分类变量,最早由Scott在1955年提出了π系数,如今应用最广泛的是kappa系数[1-3],之后,Fleiss和Conger把kappa拓展到多个评价者中,但是依然存在kappa悖论问题。在2008年,Gwet提出了一个更稳健的一致性评价系数AC1[4-5],其不受评价者边缘概率分布的影响,但是有研究者提出其方差估计方法有一定的缺陷[6]。近期,又有学者Locatelli[7]提出了以“intra-class odds ratio”的概念来评价一致性,但是其分布范围在0到无穷大,不易量化评价一致性结果。为了克服kappa悖论,以及实现更高准确性和稳定性的一致性评价,本文针对二分类变量提出了一种新的基于AC1系数的一致性评价方法CEA(coefficient of evaluation agreement),该方法在AC1系数的理论基础上推导出不同测量者(或不同测量方法)阳性事件率之间的关系来估计阳性事件率及偶然一致性,并通过探究阳性事件率和偶然一致性对整体一致性的影响,利用各个概率之间的关系式及取值范围来估计整体一致性。为验证CEA系数的准确性与稳定性,本文对kappa、AC1、CEA系数进行了模拟比较。

1 材料和方法 1.1 Kappa系数Kappa系数[10-13]是目前使用最广泛的一致性评价指标,一般适用于二分类以及多分类结局变量,加权kappa适用于有序变量,其公式组成部分主要由观测一致性和偶然一致性两部分组成。假定有A和B两个评价者将样本量为n的同一份样本分为1和0两类,结果可以通过以下2×2四格表给出,其中nij表示评价者A和B把研究对象分别分到类别i和类别j的个数,n1+,n0+和n+1,n+0分别代表评价者A和B把总样本分到类别1和0的总数。

Cohen所提出的针对二分类和多分类kappa计算公式为:

| $ \kappa = \frac{{{p_o} - {p_{c\left| \kappa \right.}}}}{{1 - {p_{c\left| \kappa \right.}}}} $ | (1) |

此处,

然而,Feinstein和Cicchetti发现kappa系数有两个悖论[14-15],第一,kappa的大小受阳性一致率与阴性一致率差值的影响,因此会出现与观测一致性相差较大的情况;第二,kappa系数会受评价结果边缘分布的影响:在其他条件不变的条件下,相比于边缘分布均衡,其分布不均衡时的kappa值会偏大。

1.2 AC1系数AC1首先由Gwet提出[4, 16-17],其给予一致性评价一种全新的解释:首先,将评价结果分为确定评价和随机评价两个部分,假定评价者做出随机评价的概率为ri(i为评价者A或评价者B),当评价者做出随机评价时,其将会有0.5的概率做出正确的判断;其次,假定当两个评价者做出确定的评价时,结果完全一致。因此,AC1有两个使用前提:第一,当评价者做出随机判断即认为出现偶然一致性;第二,当评价对象有部分不确定时即做出随机评价。相应的结果如表 2所示。

| 表 2 基于AC1方法的两评价者的评判结果分布 Table 2 Distribution of n participants by two raters based on AC1 |

AC1的计算方法见式(2):

| $ A{C_1} = \frac{{{p_o} - {p_{c\left| {A{C_1}} \right.}}}}{{1 - {p_{c\left| {A{C_1}} \right.}}}} $ | (2) |

其中

| $ \begin{array}{l} {p_o} = \frac{{{n_{11}} + {n_{00}}}}{n} = \\ \frac{{{n_{11RR}} + {n_{00RR}} + {n_{11CR}} + {n_{00CR}} + {n_{11RC}} + {n_{00RC}} + {n_{11CC}} + {n_{00CC}}}}{n} \end{array} $ |

可见,AC1的公式形式类似于kappa系数,不同在于偶然一致性pc|AC1的计算:AC1系数假定pc|AC1需要同时服从上述假定。因为在实际情况中pc|AC1不能够得到,AC1方法用以下公式来估计pc|AC1 :

| $ {p_{c\left| {A{C_1}} \right.}} = 2q\left( {1 - q} \right) $ | (3) |

其中

以下将介绍本文提出的一种新的基于AC1系数的一致性评价方法CEA。

1.3 一致性估计系数CEA除了前述AC1系数,还有Scott's π、G-index等,这些一致性系数的不同主要体现在偶然一致性pc的构建。由于不同的pc估计方法会影响到其自身的估计误差,进而会影响到最终结果的准确性。本文在AC1的基础上提出了一种新的一致性评价方法CEA。首先,为了对比多种一致性系数先来定义一下金标准T。金标准的计算公式结构采用kappa家族的公式结构,通过观测一致性po和偶然一致性pc获得(式4):

| $ T = \frac{{{p_o} - {p_c}}}{{1 - {p_c}}} $ | (4) |

式中,

和Kappa系数的公式结构类似,本研究所提出的CEA系数校正了其中的偶然一致性。假定有两个评价者A和B对同一个样本进行评判,二分类评判结果用0和1表示,评价者A有ra的概率做出随机评判,评价者B有rb的概率做出随机评判,当任意一个评价者做出随机评判时,他们将以0.5的概率做出正确的评判。并且假定当两个评价者都做出确定的评判时,评价结果完全相同。评价者A和评价者B把所有研究对象分到类别1中的概率分别为pa和pb,即表 1中pa = n1+/n,pb = n+1/n,评价者A和评价者B同时把同一个测评对象分到同一个类别的概率为po,即表 1中po =(n11 + n00)/n,代表总观测一致性,样本的阳性事件率为pr。因为当评价者A和B做出随机评判时,他们都将以0.5的概率做出正确的判断,那么可以根据以下公式[4]估计偶然一致性

| $ {{\hat p}_c} = \frac{1}{2}\left( {{{\hat r}_a} + {{\hat r}_b} - {{\hat r}_a}{{\hat r}_b}} \right) $ | (5) |

| 表 1 两评价者的四格表评判结果 Table 1 A 2×2 contingency table to assess agreement of two raters |

其中,

| $ {p_a} = {p_r} - \frac{1}{2}{p_r}{r_a} $ | (6) |

| $ {p_b} = {p_r} - \frac{1}{2}{p_r}{r_b} $ | (7) |

| $ {p_o} = 1 - \frac{1}{2}\left( {{r_a} + {r_b}} \right) + \frac{1}{2}{r_a}{r_b} $ | (8) |

由上述公式计算可得:

| $ f\left( {{p_r}} \right) = \left( {{p_o} - 1} \right)p_r^2 + \left( {{p_a} + {p_b}} \right){p_r} - 2{p_a}{p_b} $ | (9) |

其中pa、pb和po可直接由原始数据获得,则最终可通过解一元二次方程f(pr) = 0来估计pr,根据定义可知pr取值范围为0~1,当一元二次方程在取值范围内有两个解,则取更靠近pa及pb均值的值作为pr;当一元二次方程在在取值范围内有且只有一个解,则取唯一解作为pr;当一元二次方程无解时,因po的取值范围为0~1,取一元二次方程f(pr)最大值作为pr。那么,最终CEA的计算公式如下:

| $ CEA = \frac{{{p_o} - {{\hat p}_c}}}{{1 - {{\hat p}_c}}} $ | (10) |

这里

为比较本研究所提出的一致性评价方法CEA的准确性,本文对kappa、AC1、CEA及其方差在多种情况下做了蒙特卡罗模拟。首先,模拟一组样本量为N并由0~1为元素的二分类变量,其阳性事件率为pr;其次分别以ra和rb的概率从中抽取部分数据,再将这部分数据以0.5的概率赋值0或者1;最后将新赋值后的这部分数据放回原数据中,此过程将产生两组数据,分别代表两个评价者A和B的评判结果。真实的一致性T将由公式(4)计算得出,kappa、AC1和CEA将由评价者A和B的评判结果组成的2×2四格表计算得出。之后,本文对各个一致性系数的方差也做了模拟,参数设置如下:样本量N=20、60、80、100,样本的阳性事件率pr =0.95、0.85、0.75、0.55,评价者A和B发生随机评判的概率ri =0.05、0.2;各种情形下均模拟10 000次。

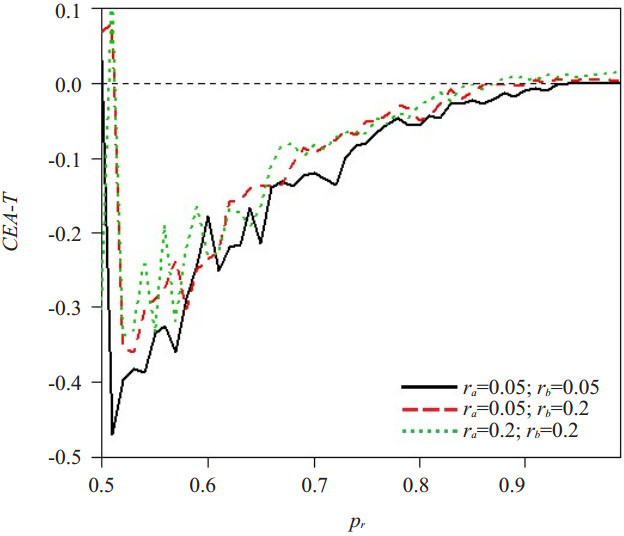

2 结果 2.1 模拟结果随着阳性事件率pr的增长,CEA对真实一致性T的估计偏差逐渐减小,图 1展示了两个评价者的随机评判概率为0.05、0.2不同组合下的结果。鉴于不同的pr条件下,图 1是以0.5为中心左右对称的,此处只展示了pr在0.5~1范围内CEA的估计偏差。

|

图 1 CEA的估计偏差(CEA-T)与阳性事件率pr的关系 Figure 1 Relation of difference between CEA and real interrater reliability T with the positive rate pr. The abscissa represents the sample positive rate pr, the ordinate represents the difference between the estimated values and the true values of the inter-rater reliability CEA-T, ra and rb represent the probability of rater A and rater B to perform a random rating respectively. |

当pr =0.95时,金标准T和kappa、AC1、CEA的偏差见表 3。系数偏差

| 表 3 当pr=0.95时不同样本量和随机评判率下各个系数偏差 Table 3 Bias of agreement coefficients for different sample sizes and random rating rates with pr=0.95 |

样本量和阳性事件率pr对各个系数方差的影响结果见表 4。

| 表 4 各个系数的方差 Table 4 Variance of agreement coefficients* |

方差

此实例描述了描述了巴塞罗那及西班牙的72岁以上老年人步行和从椅子上站起来的困难程度,并进行了基本的测量(步行速度和chair-stand测试)[18]。并进行了基本的测量(步行速度和chair-stand测试)。表 5显示了对是否在行走时需要帮助和是否可以完成4米步行的基本测量结果和自评结果的比较。

| 表 5 巴塞罗那及西班牙的基本测量结果与自评结果之间的一致性 Table 5 Agreement between reported disability and observed performance in a sample of individuals in Barcelona, Spain |

这是一个关于kappa悖论典型的例子,根据公式(1)、(2)、(9)可以得出kappa、AC1、CEA的估计值分别为0.519、0.920、0.961,从表格给出的结果可以看出观测一致性很高(po = 0.962),但是kappa系数却显示出很低的一致性,而CEA与AC1的结果类似,并且都不受边缘概率分布的影响。

3 讨论近些年,在医学领域评价不同方法或者不同评价者之间的一致性受到了极大的关注[19-21]。然而,这些方法都有他们各自的限制条件,最典型的就是kappa悖论,为克服该缺陷,并提高准确性,本研究提出了一种新的针对二分类变量的一致性评价方法CEA。类似于kappa[1, 22-25]和AC1系数的公式结构,CEA对偶然一致性进行了校正,为了估计最接近真实值的偶然一致性,本研究探索了两个评价者做出随机评价概率ra、rb与阳性事件发生率pr之间的关系,并通过解一元二次方程及概率本身的取值范围来确定最终的估计值。与AC1类似,CEA也有如下假设前提:(1)评价者A和B都会有一定的概率做出随机评判,并且当他们做出随机评判时,他们将以0.5的概率做出正确的判断。(2)当两个评价者对同一个测评对象做出确定评判时,两者的评判结果将完全一致。

为了评估CEA的可靠性,本研究对kappa、AC1和CEA进行了模拟研究。结果显示,在我们所设置的不同的样本量(20、60、80或100)、阳性事件率(0.95、0.85、0.75或0.55)以及随机评判概率(0.05或0.2)条件下,CEA和金标准的偏差始终最小,说明CEA的准确性高于kappa和AC1;随着pr的减小,CEA的准确性增高,即使阳性事件率接近于极值的情况下,CEA仍没有受到边缘概率分布的影响且始终保持高度的准确性;在方差模拟结果中,在我们所设置的不同的样本量(同上)、阳性事件率(同上)以及随机评判概率(ra = rb =0.05)条件下,CEA估计值的方差小于AC1估计值的方差,虽然当pr =0.55、0.75、0.85时,kappa估计值的方差部分小于AC1和CEA估计值的方差,但是kappa估计值的方差和CEA估计值的方差差别并不大,并且CEA解决了kappa悖论的问题,即使在小样本的情况下依旧表现良好。因此,无论是在准确性还是稳定性的方面考虑,CEA都是一个值得推荐的一致性评价方法。

但CEA也有不足之处,由图 1可知,当阳性事件率pr在0.5~0.6时,CEA与真实一致性T的差值波动较大,但是其准确性仍高于kappa和AC1。此外,模拟中发现虽然评价者的随机评判概率的估计误差较大,但由于偶然一致性的计算结合了两个随机评判概率的乘积与加和,最终对偶然一致性的估计误差影响较小,使得CEA准确性仍高于kappa和AC1。上述问题有待于进一步研究。

| [1] |

Kvalseth TO. A coefficient of agreement for nominal scales:an asymmetric version of kappa[J].

Educ Psychol Meas, 1991, 51(1): 95-101.

DOI: 10.1177/0013164491511008. |

| [2] |

Vanbelle S. A new interpretation of the weighted kappa coefficients[J].

Psychometrika, 2016, 81(2): 399-410.

DOI: 10.1007/s11336-014-9439-4. |

| [3] |

Van Der Wulp I, Van Stel HF. Calculating kappas from adjusted data improved the comparability of the reliability of triage systems: a comparative study[J].

J Clin Epidemiol, 2010, 63(11): 1256-63.

DOI: 10.1016/j.jclinepi.2010.01.012. |

| [4] |

Gwet KL. Computing inter-rater reliability and its variance in the presence of high agreement[J].

Br J Math Stat Psychol, 2008, 61(Pt 1): 29-48.

|

| [5] |

Wongpakaran N, Wongpakaran T, Wedding D, et al. A comparison of Cohen's Kappa and Gwet's AC1 when calculating inter-rater reliability coefficients: a study conducted with personality disorder samples[J].

BMC Med Res Methodol, 2013, 13(1): 61.

DOI: 10.1186/1471-2288-13-61. |

| [6] |

Gwet KL. Variance estimation of nominal-scale inter-rater reliability with random selection of raters[J].

Psychometrika, 2008, 73(3): 407.

DOI: 10.1007/s11336-007-9054-8. |

| [7] |

Locatelli I, Rousson V. Assessing interrater agreement on binary measurements via intraclass odds ratio[J].

Biom J, 2016, 58(4): 962-73.

DOI: 10.1002/bimj.v58.4. |

| [8] |

Almehrizi R. Normalization of mean squared differences to measure agreement for continuous data[J].

Stat Methods Med Res, 2016, 25(5): 1955-74.

DOI: 10.1177/0962280213507506. |

| [9] |

Morgan CJ, Aban I. Methods for evaluating the agreement between diagnostic tests[J].

J Nucl Cardiol, 2016, 23(3): 511-3.

DOI: 10.1007/s12350-015-0175-7. |

| [10] |

郭轶斌, 郭威, 秦宇辰, 等. 基于Kappa系数的一致性检验及其软件实现[J].

中国卫生统计, 2016, 33(1): 169-70.

|

| [11] |

Sagawa J, Armand S, Lubbeke A, et al. Associations between gait and clinical parameters in patients with severe knee osteoarthritis: A multiple correspondence analysis[J].

Clin Biomechanics, 2013, 28(3): 299-305.

DOI: 10.1016/j.clinbiomech.2013.01.008. |

| [12] |

Warrens MJ. Chance-corrected measures for 2×2 tables that coincide with weighted kappa[J].

Br J Math Stat Psychol, 2011, 64(Pt 2): 355-65.

|

| [13] |

Lin L, Hedayat AS, Wu W. A unified approach for assessing agreement for continuous and categorical data[J].

J Biopharm Stat, 2007, 17(4): 629-52.

DOI: 10.1080/10543400701376498. |

| [14] |

Cicchetti DV, Feinstein AR. High agreement but low kappa: Ⅱ. Resolving the paradoxes[J].

J Clin Epidemiol, 1990, 43(6): 551-8.

DOI: 10.1016/0895-4356(90)90159-M. |

| [15] |

Byrt T, Bishop J, Carlin JB. Bias, prevalence and kappa[J].

J Clin Epidemiol, 1993, 46(5): 423.

DOI: 10.1016/0895-4356(93)90018-V. |

| [16] |

公为洁, 温兴煊, 何贤英, 等. 一阶一致性系数AC1对二分类结局一致性的测评[J].

中国卫生统计, 2015, 32(5): 774-6.

|

| [17] |

公为洁, 赵志, 顾豪高, 等. 二分类资料的五种一致性评价指标应用效果比较[J].

中国卫生统计, 2016, 33(4): 636-8.

|

| [18] |

Ferrer M, Lamarca R, Orfila F, et al. Comparison of performancebased and self-rated functional capacity in Spanish elderly[J].

Am J Epidemiol, 1999, 149(3): 228-35.

DOI: 10.1093/oxfordjournals.aje.a009796. |

| [19] |

Erdoğan S, Temel GO. A comparison of the sensitivity, specificity and prevalence response of coefficients of individual agreement (CIA)with cohen's kappa and Gwet'sAC1 statistics[J].

Turk Klin Tip Bilim, 2015, 7(1): 25-38.

|

| [20] |

Tsai MY. Assessing inter-and intra-agreement for dependent binary data: a Bayesian hierarchical correlation approach[J].

J Appl Stat, 2012, 39(1): 173-87.

DOI: 10.1080/02664763.2011.578623. |

| [21] |

Cao H, Sen PK, Peery AF, et al. Assessing agreement with multiple raters on correlated kappa statistics[J].

Biom J, 2016, 58(4): 935-43.

DOI: 10.1002/bimj.v58.4. |

| [22] |

Feuerman M, Miller AR. Relationships between statistical measures of agreement: sensitivity, specificity and kappa[J].

J Eval Clin Pract, 2008, 14(5): 930-3.

DOI: 10.1111/j.1365-2753.2008.00984.x. |

| [23] |

Tang W, Hu J, Zhang H, et al. Kappa coefficient: a popular measure of rater agreement[J].

Shanghai Arch Psychiatry, 2015, 27(1): 62-7.

|

| [24] |

Marasini D, Quatto P, Ripamonti E. Assessing the inter-rater agreement for ordinal data through weighted indexes[J].

Stat Methods Med Res, 2016, 25(6): 2611-33.

DOI: 10.1177/0962280214529560. |

| [25] |

Wright KC, Melia J, Moss S, et al. Measuring interobserver variation in a pathology EQA scheme using weighted κ for multiple readers[J].

J Clin Pathol, 2011, 64(12): 1128-31.

DOI: 10.1136/jclinpath-2011-200229. |

2018, Vol. 38

2018, Vol. 38